Egy hely - a helyes beállítást

Ebben és szükségességét a használati utasítást, a keresőprogramok nem kivételek a szabály alól, és így jön ki egy speciális fájl robots.txt segítségével. Ezt a fájlt kell lennie gyökérmappájába webhelyén, vagy lehet virtuális, de mindig nyitva: www.vashsayt.ru / robots.txt

A keresőmotorok már régóta megtanulta megkülönböztetni szükséges html fájlokat a belső szkriptkésztletet a CMS rendszer, vagy inkább, megtanulták felismerni linkeket tartalom-alapú termékek és mindenféle szemetet. Ezért sok webmester felejtsd el, hogy a robotok saját telek, és úgy gondolja, hogy minden olyan jó. Igen, igazuk van a 99% -os, mert ha a webhely nem rendelkezik ezzel a fájlt, akkor a keresők korlátlanok a keresési tartalmi, de ez nem történik árnyalatok hibát, hogy tud vigyázni előre.

T o Mi a robots.txt

A robots.txt fájl jön létre beállítására megfelelő webhely indexelése a keresőmotorok. Ez azt jelenti, hogy olyan szabályokat tartalmaz, engedélyek és tiltásokat egyes utak a webhely vagy a tartalom típusát. De ez nem egy csodaszer. Minden szabály a robotok fájl nem jelzi pontosan követi őket, hanem egyszerűen egy ajánlást a keresőmotorok. A Google például a következőket írja:

Nem használhatja a robots.txt fájlt, hogy elrejtse az oldalt a Google keresési eredményei között. Ez utalhat más oldalakra, és hogy továbbra is indexelve.

Keresés robotok eldönteni, hogy mit index, és mi nem, és hogyan viselkednek az oldalon. Minden keresőbe céljait és működését. Mintha nem akarta, ahogy vannak nem szelíd.

De van egy trükk, hogy nem alkalmazható közvetlenül tárgya a cikk. Ahhoz, hogy teljesen megakadályozzák a robotok az index, és azt mutatják oldalait a keresési eredményeket, meg kell írni:

Térjünk vissza a robotokat. Szabályok ezt a fájlt, akkor zárja be, vagy lehetővé teszi a hozzáférést a következő típusú fájlok:

- A nem grafikus fájlokat. Ez főleg html fájlokat, amelyek bármely információt. Bezárhatja a duplikált oldalt vagy oldalakat, amelyek nem hordoznak semmilyen hasznos információt (oldal oldalszámozás, naptár oldalon, archívumok oldal, profil oldalon, stb.)

- Képfájlokat. Ha azt szeretnénk, hogy helyén a képek nem jelennek meg a kereső, akkor regisztráljon a robotok fájlt.

- forrás fájlokat. Szintén segítségével a robotok, letilthatja az indexelés különböző szkriptek, CSS stíluslap fájlt, és egyéb források lényegtelen. De ne rögzítse források, amelyek felelősek a vizuális része a helyszínen a látogatók számára (például, ha bezárja a css és js hely, amely megjeleníti szép tömb vagy asztalra, nem lát egy keresési robot, és megesküszik rá).

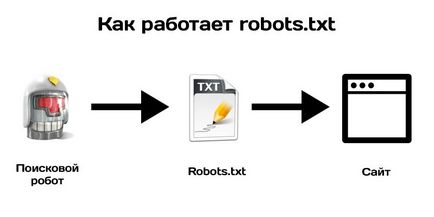

Annak illusztrálására, hogy egy robot működik, nézd meg az alábbi képen:

A intaksis robots.txt fájl

Írni a szabályokat keresők robotok fájl több használhatók a különböző paramétereket, amelyekkel a robotok követik. Kezdjük az első és talán a legfontosabb irányelveket:

Az irányelv: User-agent

User-agent - Ez a direktíva meghatározza a neve a robot meg, hogy ki használhatja ajánlásokat a fájlt. Ezek a robotok hivatalosan az internet világában - 302 darab. Ön bizonyára tudja szabályokat írnak elő mindenki egyénileg, de ha nincs ideje rá, majd csatlakoztatni:

* -in ez például azt jelenti, „minden”. Ie A fájl robots.txt, meg kell kezdeni, „akiknek van” szánt fájlt. Annak érdekében, hogy ne zavarja a nevét, a robot, csak felsorolja a „csillag” az irányelv felhasználói ügynök.

Adok részletes listát a legnépszerűbb keresők robotok:

Google - Googlebot - a fő robot

A többi Google robotok

Yandex - YandexBot - alapanyagok indexelés robot;

A többi robot Yandex

Az irányelv tiltása és engedélyezése

Tiltása - a legalapvetőbb szabály robotok, ezen keresztül az irányelv akkor Indexelés kikapcsolása bizonyos helyen a webhelyen. Írásbeli irányelv az alábbiak szerint:

Gyakran lehet megfigyelni irányelv Disallow: üres, vagyis az állítólag azt mondta a robot, hogy semmi sem tilos az oldalon indexelni kívánt. Légy óvatos! Ha fel / tiltási, akkor zárja el teljesen a helyén az indexelés.

Ezért a legtöbb szabványos változata robots.txt, amely „lehetővé teszi, hogy az indexelés az egész oldal minden keresőmotorok” a következő:

Ha nem tudja, mit kell írni a robots.txt, de valahol hallottam róla, egyszerűen másolja a fenti kódot, mentse el a fájlt a robots.txt és töltse fel a gyökér a webhelyen. Vagy nem hoz létre semmit, mert e nélkül a robotok index mindent a honlapon. Vagy olvassa el a történetet, hogy a végén, és akkor rájönnek, hogy a telep lezárásának és mi nem.

Szabályai szerint a robotok, tiltsa irányelv kötelezővé kell tenni.

Ez az irányelv lehet kapcsolni egy mappát vagy egy fájlt.

Ha le szeretné tiltani egy mappát, akkor írj:

Ha azt szeretnénk, hogy megakadályozzák egy adott fájlt:

Ha azt szeretnénk, hogy korlátozhatja bizonyos fájltípusok:

A reguláris kifejezések nem támogatja számos keresőprogram. A Google támogatja.

Hagyjuk - felbontás irányelv Robots.txt. Ez lehetővé teszi, hogy a robot index egy bizonyos utat, vagy abban a könyvtárban tiltja. Csak Yandex is használták egészen a közelmúltig. Google utolérte, és elkezd használ ez is. Például:

Ezek az irányelvek megtiltják index a teljes weboldal tartalmát, kivéve a tartalom mappát. Vagy itt egy másik népszerű irányelvnek az utóbbi időben:

Ezek az értékek lehetővé teszik az index minden CSS és JS fájlok az oldalon. de megtiltják az index minden egy mappát a sablon. Az elmúlt évben a Google küldött sok e-mailt webmesterek ilyen tartalom:

Googlebot nem tudta elérni a CSS és JS fájlok online

Ha hozzá a két lehetővé az irányelv, amelyek meg vannak írva az utolsó kódot a robots.txt, akkor nem fogja látni az ilyen üzeneteket a Google.

És Speciális karakterek használata robots.txt

Most, a jelek az irányelvek. Főszereplők (speciális karakterek), hogy megakadályozza, vagy lehetővé teszi /, *, $

Pro jeleket (perjel) «/»

Slash nagyon megtévesztő robots.txt. Néztem több tucat alkalommal egy érdekes helyzet, amikor tudatlanul adunk a robots.txt:

Nézd meg figyelmesen az összes / robots.txt

Mindig a végén a könyvtár put /. Ha fel / tiltása be, akkor letiltja az indexelés az egész oldalon, de ha nem teszed a / engedélyezése, akkor is letiltja az indexelés az egész oldalon. / - bizonyos értelemben azt jelenti: „Minden, ami a következőképpen irányelv /.”

A csillag * a robots.txt

Speciális karakter * jelentése bármely (beleértve az üres is) karaktersor. Akkor tudja használni bárhol a robotok például:

Megtiltja minden fájl kiterjesztését aspx a PAPKA könyvtárban is tiltja nemcsak a mappa / régi, de az irányelv / PAPKA / régi. Zamudreno? Ez az, amit javasoljuk, hogy ne merüljön a * a robotok.

Alapértelmezésben fájlindexelés szabályok és a tilalom * robots.txt irányelvek egyáltalán!

$ Speciális karakter robotok befejezi a * helyettesítő. Például:

Ez a szabály tiltja a „/ menü”, de nem tiltja „/menu.html”, azaz fájl meggátolja keresők csak irányelv / menüt, nem tudja megakadályozni az összes fájlt a szót menü URL`e.

A gazda irányelv

Jellemzően a fogadó csak munkákkal Yandex, ezért nem szükséges. meghatározza a fő domain a tükör helyén, ha van ilyen. Például van a domain dom.com, de ugyanaz kell vásárolni, és adja meg a következő területeken: dom2.com, dom3, com, dom4.com és velük van egy átirányítást az elsődleges tartomány dom.com

Yandex gyorsan meghatározni, melyik közülük a fő honlapján (host), sorolja fel a fogadó könyvtár robots.txt:

Felvétel host kell lennie egy, és ha szükséges, tönkölybúza port. (Host: staurus.net:8080)

Az irányelv Crawl-delay

Ez az irányelv célja az volt, hogy távolítsa el a lehetőségét, hogy a terhelés a szerveren. Kereső robotok tehetünk száz kérés ugyanakkor az oldalon, és ha a szerver gyenge, ez okozhat kisebb hibák. Ahhoz, hogy ez nem történt meg, hogy dolgozzon ki egy szabályt robotok Crawl-delay - ez a minimum közötti időszakban a letöltési oldalon a webhelyen. Tipikus érték készletben irányelvek javasolják 2 másodpercig. A robotok, ez így néz ki:

Ez az irányelv működik Yandex. A Google, beállíthatja a szkennelési frekvencia a panel webmaster alatt Webhely beállításai a jobb felső sarokban a „fogaskerék”.

Irányelv D Clean-param

Yandex robot, ezt az információt nem lesz többször újraindítani ugyanazt az információt. Így hatékonyságának növelése a webhely feltérképezését, csökkenti a szerver terhelését.

Például az oldalon van egy oldal:

www.site.com/some_dir/get_book.pl?ref=site_1book_id=123

www.site.com/some_dir/get_book.pl?ref=site_2book_id=123

www.site.com/some_dir/get_book.pl?ref=site_3book_id=123

Az irányelv Oldaltérkép

Ez az irányelv csak adja meg a helyét az sitemap.xml. A robot memorizálja azt, „mondja köszönöm”, és folyamatosan elemzi az előre meghatározott úton. Úgy néz ki, mint ez:

ÁLTALÁNOS kérdésekre, és ajánlásokat robotok

És most nézzük meg a közös problémák merülnek fel, hogy a készítmény a robotok. Az interneten, sok ilyen téma, így elemzi a legfontosabb ezek közül a leggyakoribbak.

P ht robots.txt

Sok, de a „jó”, mert az azonos helyszínen azonos CMS lesz megfelelő, és a többi CMS - visszatér a hibákat. „Egy megfelelően konfigurált” minden helyszínen külön-külön. A robots.txt kell zárni indexelni ezen részeit azokat a fájlokat, amelyek nem szükségesek a felhasználók és nem hordoznak semmilyen értéket keresők. A legegyszerűbb és legjobb megoldás robots.txt

R obots.txt a WordPress

Ismét egy csomó kérdést, a honlapon lehet online áruházak, egy másik blog, a harmadik - Landing, a negyedik - egy kis weboldal a cég, és ez mind-mind a CMS WordPress és a robotok szabályok teljesen más. Itt van az én robots.txt ezt a blogot:

Annyi lehetőség, nézzük elemezni őket.

Hagyjuk WordPress. Először engedélyező szabályokat a tartalmat, amelyet a felhasználók szeretnék (ezt a képet feltöltések mappa) és robotok (ezt CSS és JS oldalak megjelenítésére). Ez az css és js gyakran bírálta a Google, ezért hagyta őket nyitva. Ez volt lehetséges, hogy a módszer az összes fájlt, egyszerűen úgy «/*.css$», de tiltja a sor ilyen mappákat, ahol a fájlok - nem szabad használni őket az indexelés, így meg kellett állítani a mappa elérési útját, amely tiltja teljesen.

Hagyjuk mindig mutatja az utat, hogy a tiltott tartalom tiltása. Ha valamit nem tilos, nem szükséges előírni a lehetővé, állítólag azt gondolva, hogy adsz lendületet a keresőprogramok, mint a „Hát jó, az URL-t, indexelt gyorsabb.” Ez nem fog működni.

Nos Sitemap Host és szabványos irányelveket. Csak ez volt szükség ahhoz, hogy egy külön fogadó Yandex, de én nem zavarta róla. Ez talán a végén egy robots.txt WP.

H ow, hogy hozzon létre egy robots.txt

Ez nem olyan nehéz, mint amilyennek látszik első pillantásra. Csak azt kell, hogy rendszeres notebook (Jegyzettömb), és másolja az adatokat, hogy a webhely a beállítások ebben a cikkben. De ha ez neked nehéz, vannak források az interneten, amely lehetővé teszi, hogy létrehoz robotok a helyszínek:

Generátor a robotok pr-cy - Az egyik legegyszerűbb robotok generátorok RuNet. Egyszerűen írja be a szerszám linkeket, amit nem esik az index, meg minden.

Létrehozása a robotok htmlweb - jó generátor robotok képesek felvenni gazda és Sitemap.

Mr. de ellenőrizni a robots.txt

Ez az egyik legfontosabb és kötelező tételek robotok előtt küld egy fájlt a szerverre - ellenőrizze. Ha valamit rosszul, akkor „temetni” a webhely a keresők nyitott terek. Lyapom szokásos, mint ez történik, tiltsa az indexelés az egész oldalon.

Ennek elkerülése érdekében meg kell vizsgálnia a gátlások fájlba egyik kényelmes szűrés szolgáltatás:

Senki nem fogja mondani, többet a robots.txt, ezek elvtársak. Végtére is, ez nekik, és létrehozta a „tiltott, amit találtam.”

Most beszéljünk valami kis hiba, hogy lehet robotokat.

Mivel lusták Staurus.